El trastorno del espectro autista (TEA) es un trastorno del neurodesarrollo que afecta al me nos a 78 millones de niños en todo el mundo. Las evaluaciones actuales del TEA comprenden pro cedimientos observacionales semiestructurados administrados a niños y cuidadores, enfrentando algunas limitaciones, como la posible influencia de sesgos psicológicos1-3. También son consumi doras de tiempo y se administran en entornos que carecen de validez ecológica4-6. Estas limita ciones hacen que 1 de cada 4 niños que muestran signos de TEA no reciben un diagnóstico7.

Una tendencia reciente en la investigación del TEA sugiere utilizar una perspectiva interdisci plinaria para hacer diagnóstico, implementando la detección automática y objetiva de biomarca dores clínicos1. De hecho, mejorar el diagnóstico del TEA mediante el uso de herramientas de de tección precisas y objetivas capaces de identi ficar biomarcadores puede mejorar la precisión de la evaluación y aumentar el acceso a la inter vención temprana.

Hasta la fecha, se han probado muchos proce dimientos de detección del TEA8-10. Sin embargo, la mayoría de ellos se basan en la detección de un solo biomarcador, mientras que la evaluación no se realiza en entornos ecológicos. Este enfoque unimodal puede no ser eficiente para detectar la variedad de síntomas típicos del TEA. Los proce dimientos actuales abogan por la detección mul timodal y ecológica de biomarcadores del TEA1. En este sentido, solo hay algunos estudios que detectan el TEA utilizando procedimientos tanto multimodales10,11 como entornos ecológicos4,5,12.

Notablemente, las nuevas tecnologías ofrecen la oportunidad de fusionar estas necesidades de evaluación del TEA mediante la recopilación de biomarcadores clínicos digitales en entornos eco lógicos. En particular, los sistemas semi-inmersi vos de realidad virtual (RV) parecen adecuados para desarrollar herramientas de detección del TEA basadas en la recopilación multimodal y ecológica de biomarcadores digitales1,4-6,12-14.

En este estudio, se presenta la validación de un novedoso y ecológico procedimiento clínico de RV para evaluar objetivamente el TEA me diante biomarcadores digitales multimodales. Los biomarcadores digitales se prueban por se parado para evaluar el TEA y finalmente se com binan utilizando un enfoque multimodal para la evaluación.

Materiales y Métodos

Participantes

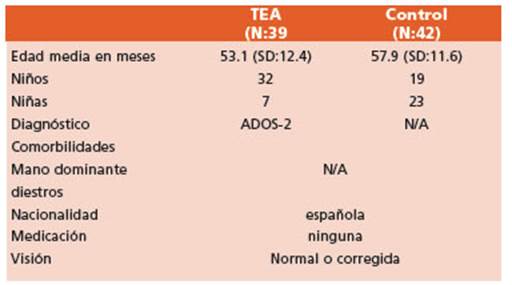

81 niños, cuyas edades oscilaban entre los 3 y 7 años, participaron en el estudio. Las características de la mues tra se presentan en la Tabla 1.

Los participantes fueron reclutados por el Centro de Desarrollo Cognitivo Red Cenit de Valencia, a través de la promoción del estudio en las redes sociales. La parti cipación fue voluntaria y gratuita. El Comité Ético de la Universidad Politécnica de Valencia aprobó el estudio (ID: P_06_04_06_20).

El sistema de RV

El sistema de RV utilizado en el estudio fue una CAVE con las mismas características de estudios anteriores6,13,14. La interacción del usuario en el sistema de RV se realizó a través del Azure Kinect DK. La profundidad de campo de la cámara permitió el seguimiento del cuerpo del par ticipante en toda la habitación. La Figura 1 presenta una imagen de la configuración experimental.

La experiencia virtual

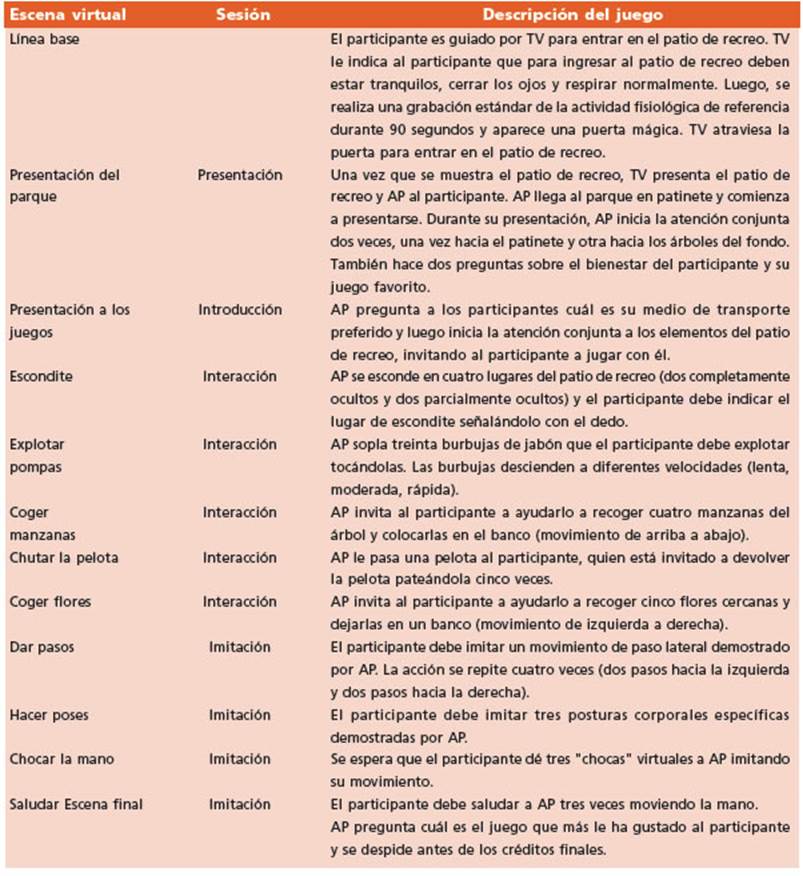

La experiencia virtual se asemejaba a un parque in fantil en el que hay dos avatares: 1) el avatar principal (AP), que es un niño que guía al usuario a lo largo de la experiencia, y 2) el terapeuta virtual (TV), que presenta a los participantes el entorno y los ayuda cuando no inte ractúan como se espera. El TV se puede personalizar se gún las preferencias, eligiendo entre un TV masculino o femenino. La Tabla 2 presenta una descripción detallada de la experiencia virtual.

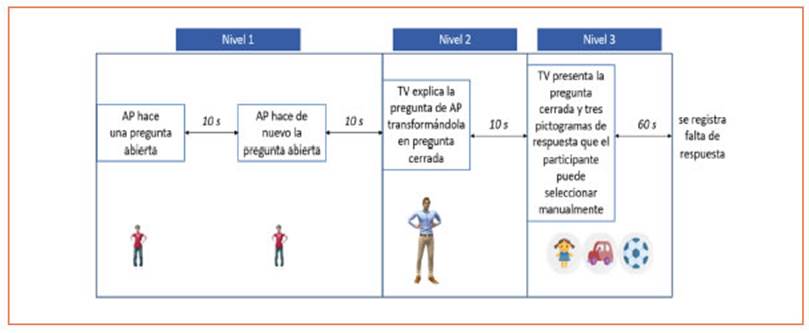

En la primera escena de la sesión de presentación se libera el olor de hierba mojada para fomentar el nivel de inmersión en el entorno. En cuanto a las preguntas for muladas por AP en esta sesión, los participantes pueden responder en tres niveles diferentes (Figura 2). Cuando el participante responde a la pregunta, se omiten los niveles posteriores.

Posteriormente, en la sesión de interacción, se liberan los olores de manzana y rosa en las escenas virtuales co rrespondientes.

En las escenas virtuales de ambas sesiones, si el parti cipante no interactúa como se espera, después de 45 se gundos aparece TV explicando cómo jugar. Este guion se repite 3 veces en caso de que el participante no realice la acción requerida. Después de tres intervalos de 45 segun dos sin respuesta por parte del participante, se registra una respuesta nula.

El orden de presentación de las sesiones de imitación e interacción fue aleatorio, al igual que el orden de las escenas dentro de las sesiones.

Procedimiento experimental

El estudio se llevó a cabo en una sesión única. Al principio, los participantes podían elegir entre una fi gura humana virtual masculina o femenina, y se uti lizó el mismo procedimiento que en Minissi et al.6,13,14 para fomentar el meta-auto-reconocimiento en la fi gura.

Después de esta fase de familiarización, se presentó un breve video del parque virtual para fomentar la acep tación y familiarización con el entorno virtual, especial mente en niños con TEA y de corta edad.

Después del breve video, comenzó la escena de graba ción de referencia.

Durante la experiencia de RV, se registraron cuatro bioseñales para detectar biomarcadores digitales: rendi miento comportamental, habilidades motoras, actividad electrodermal (EDA) y movimientos oculares. Los movi mientos oculares se registraron solo en la sesión de pre sentación, mientras que las otras bioseñales se midieron durante toda la experiencia de RV. El registro de movimien tos oculares se realizó solo en la sesión de presentación debido a limitaciones ergonómicas de las gafas de segui miento ocular cuando se utilizan con niños pequeños.

Recogida de los datos y extracción de los biomarcadores digitales

De cada bioseñal, se extrajo una serie de ca racterísticas con el fin de caracterizar las res puestas de los participantes a la experiencia vir tual. Estos biomarcadores digitales se utilizaron más tarde para entrenar modelos de aprendiza je automático con el fin de distinguir entre niños con TEA y niños control.

Los biomarcadores de rendimiento comporta mental están representados por el tiempo de reac ción de los participantes, la precisión y el número de pautas en las tareas virtuales y en las escenas virtuales con preguntas. Para calcularlos, se utili zó un registro personalizado creado en Unity® que informaba la marca de tiempo de cada elemento que aparecía y las acciones del usuario.

Para la grabación de habilidades motoras, el Azure Kinect DK registró los movimientos de todo el cuerpo de los participantes median te un algoritmo de visión por computadora. Se implementó un método automático de detec ción de participantes basado en la continuidad del movimiento y la altura de los participantes para distinguir entre los movimientos del niño y del experimentador. Una vez identificado el participante, se aplicó una técnica de suavizado para reducir el ruido debido a la baja precisión del dispositivo. Luego, se obtuvieron métricas de habilidades motoras para todas las partes del cuerpo. Estas métricas consistieron en el valor medio, máximo y mínimo del desplazamiento, velocidad, aceleración y aceleración tangencial entre fotogramas consecutivos, así como la po sición. También se registró el número de valores faltantes.

La EDA se registró durante la experiencia virtual mediante la pulsera Empatica E4. La señal cruda se segmentó basándose en las escenas virtuales y la señal de EDA entre las escenas se descartó. La EDA en cada escena virtual se procesó primero para reducir el número de artefactos en la señal, aplicando corrección automática de artefactos mediante interpolación con un spline. En segundo lugar, se extrapolaron los componentes fásicos y tónicos de la señal mediante el análisis continuo de descomposición. Los dos componentes se pro cesaron para obtener diferentes métricas: para la línea de base de la EDA, se calcularon la media, desviación estándar, mediana y energía espectral de los dos componentes, y el número de picos por minuto del componente fásico. Los picos se iden tificaron mediante máximos locales mediante la comparación de valores adyacentes, considerando una amplitud mínima de 0.05 μS y un ancho míni mo de 1 s a la mitad de la altura de prominencia. También se midieron la amplitud media y máxi ma del pico. Para la EDA en cada escena virtual, los dos componentes se re-escalaban dividiéndolos por sus correspondientes en la señal de línea de base, y se calcularon las mismas métricas.

Finalmente, se utilizaron las Tobii Pro Glasses 2 para medir la mirada de los participantes du rante la sesión de presentación. Se calcularon datos semánticos y no semánticos a partir de la señal de la mirada. Los datos semánticos se re fieren a los movimientos oculares relacionados con las áreas de interés (AoIs) ubicadas en la es cena virtual, mientras que los datos no semánti cos no están relacionados con el contexto, como fijaciones, sacadas, parpadeos y diámetro pu pilar. Para los datos semánticos, los movimien tos oculares se corrigieron siguiendo un proce dimiento de calibración personalizado. Luego, la mirada calibrada registrada por las gafas se proyectó sobre las imágenes del marco central de la CAVE, y se calculó el tiempo de mirada en las AoIs. Para los movimientos oculares no se mánticos, las fijaciones se detectaron siguien do un procedimiento estandarizado y fijando un umbral mínimo de 60 ms. Para las sacadas, los movimientos oculares consecutivos con una velocidad superior a 30s se consideraron como pertenecientes a la misma sacada. Se utilizó un umbral máximo de valores faltantes de 40 ms para separar las sacadas. También se calcularon el diámetro pupilar, la velocidad de dilatación y la media y varianza de la duración de los parpa deos y los parpadeos por minuto. Los parpadeos se consideraron como una sucesión de valores faltantes más cortos que 100 ms.

Análisis de datos

Se calcularon biomarcadores digitales para cada bio señal en las escenas virtuales y posteriormente se combi naron para entrenar un clasificador específico para estas combinaciones. Los clasificadores empleados fueron Má quinas de Soporte Vectorial (SVM) con eliminación recur siva de características con validación cruzada.

El entrenamiento de todos los modelos se llevó a cabo mediante un marco de validación cruzada anidada repe tida por sujeto. Este marco incluye dos bucles: un bucle interno para el ajuste del modelo y un bucle externo para la evaluación del rendimiento. El bucle interno imple menta una validación cruzada estratificada repetida con 5 divisiones y 6 repeticiones, aplicada al subconjunto de entrenamiento del bucle externo. Su función principal es optimizar el parámetro de regularización de la SVM. Al mismo tiempo, proporciona una estimación del rendi miento del modelo.

En la validación cruzada externa, el modelo ajustado se entrena en la partición de entrenamiento, reservando una porción de los datos para pruebas subsiguientes. Este proceso externo se realiza de manera iterativa a lo largo de 5 divisiones y se repite 5 veces.

Después del entrenamiento, incorporamos un sistema de votación en cada modelo de bioseñal. Los modelos, entrenados en diferentes escenas virtuales, estimaron la probabilidad de que un sujeto tenga TEA en cada par tición de prueba. Combinamos estas predicciones para cada bioseñal utilizando un enfoque de media ponde rada, donde los pesos fueron determinados por el rendi miento de cada modelo en la validación del bucle inter no. Este paso produjo una predicción específica para cada bioseñal en cada división. Posteriormente, agregamos es tas predicciones de bioseñal para generar una predicción unificada para cada usuario en las particiones de prueba.

Para evaluar la precisión de nuestras predicciones agre gadas, analizamos su rendimiento dentro de los sujetos de prueba de cada división. Nuestras métricas de evaluación incluyeron la precisión, la tasa de verdaderos positivos (TVP), la tasa de verdaderos negativos (TVN) y el área bajo la curva característica de operación del receptor (AUC). Después de determinar estas métricas para cada división, calculamos su media y desviación estándar para estimar el rendimiento del modelo en datos no vistos y el error asociado.

Resultados

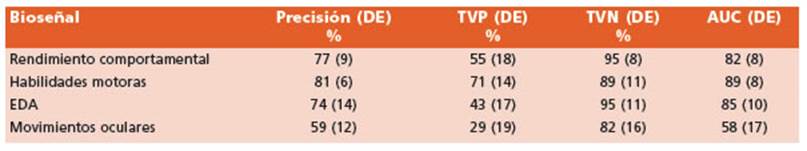

Las métricas de rendimiento relacionadas con los modelos específicos de bioseñal se en cuentran detalladas en la Tabla 3.

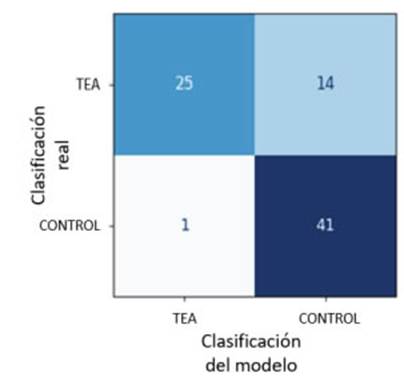

El modelo combinado que incluye los mode los específicos de bioseñal presentó una preci sión del 83% (DE = 3%), TVP del 66% (DE = 9%), TVN del 98% (DE = 6%), y AUC de 0.91 (DE = 0.04).

La Figura 3 muestra una matriz de confusión sintetizada basada en las métricas de rendi miento agregadas del modelo combinado. Los valores reflejan los verdaderos positivos, ver daderos negativos, falsos positivos y falsos ne gativos estimados a partir de las puntuaciones medias de TVP y TVN en todo el conjunto de datos.

Discusión

El presente estudio describe una novedosa herramienta ecológica de detección para la eva luación temprana del TEA mediante biomarca dores digitales. Las bioseñales registradas clasi ficaron con éxito a niños con TEA con precisión variable, que osciló entre el 59% y el 81%.

Considerando el enfoque unimodal, la biose ñal más prometedora para identificar el TEA fue la habilidad motora, confirmando el potencial de la grabación de habilidades motoras para ayudar en el diagnóstico del TEA5,6,11, incluso cuando los déficits motores aún no han sido reconocidos oficialmente como síntomas del TEA6.

En contraste con las habilidades motoras, la mirada fue la bioseñal menos efectiva. Aunque numerosos estudios han identificado eficien temente el TEA a través de movimientos ocula res11,12, nuestro hallazgo menos favorable puede atribuirse al hecho de que el modelo de gafas utilizado está diseñado para adultos en lugar de niños pequeños, así como al laborioso procesa miento que experimentaron los datos de la mira da.Para minimizar errores, estudios futuros debe rían considerar el uso de dispositivos aptos para niños que aseguren libertad de movimiento, y con procedimientos eficientes para el procesamiento de datos de mirada recogidos en pantallas muy grandes. Sin embargo, hallazgos recientes sugie ren que los movimientos oculares pueden revelar biomarcadores clínicos solo en un subtipo espe cífico de TEA15, y los procedimientos multimoda les representan el enfoque más prometedor2,10,11.

En este contexto, nuestro enfoque multimo dal logró métricas de rendimiento comparables a las de los procedimientos de evaluación tra dicionales2, identificando correctamente al 98% de los niños controles y al 66% de los niños con TEA. En un entorno clínico, esto implica que la identificación de controles es sólida, mientras que, si el sistema clasifica un caso como TEA, se requieren pruebas adicionales para confirmar el diagnóstico. Esto subraya la importancia de uti lizar esta herramienta de detección junto con los procedimientos de evaluación tradicionales.